The Machine, sebbene ancora in forma di prototipo, è finalmente una realtà. Hpe ha mantenuto la promessa, con un po' di ritardo: nel 2014, in epoca precedente alla scissione fra Hp e Hewlett Packard Enterprise, la società californiana da Las Vegas aveva annunciato un progetto a suo dire destinato a “rivoluzionare il computing”, progetto in quel momento ancora chiuso in laboratorio ma destinato a raggiungere il mercato entro un paio di anni. Ne sono passati tre, e nel frattempo la parola “rivoluzione” è diventata uno dei termini più abusati dai vendor di tecnologia, nei rispettivi ambiti d'azione. Non di meno, The Machine è effettivamente un'architettura nuova, capace di analizzare e memorizzare su un piccolo oggetto un grande volume di dati.

Nelle parole di Meg Whitman, l'amministratore delegato di Hpe, si tratta di un “ computer costruito per l'era dei Big Data”. L'obiettivo non è semplicemente l'incremento delle prestazioni di calcolo o la capacità di gestione dei Big Data, missioni già soddisfatte da tecnologie di altro tipo. The Machine si occupa, infatti, nello specifico di calcolo in-memory, puntando anche alla velocità per attività di elaborazione dati in tempo reale.

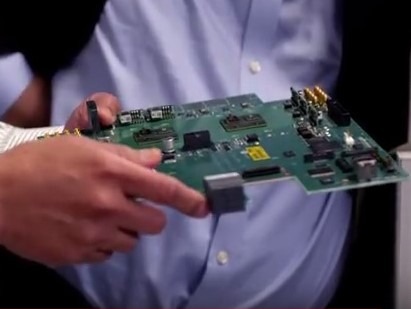

L'architettura di The Machine è basata su processori purpose-built e su un pool di memorie che comunicano fra loro grazie alla fotonica. Né una semplice memoria, dunque, né un computer fatto e finito, ma una piattaforma che potrà essere integrata all'interno di server (in data center interni alle aziende o nel cloud) e di sistemi di High performance Computing.

Il prototipo già presentato dispone di 160 terabyte di memoria, “sufficienti per lavorare simultaneamente con otto volte i dati contenuti in tutti i volumi conservati nella Libreria del Congresso statunitense, ovvero circa 160 milioni di libri”, sottolinea Hpe. E sottolinea come finora non fosse stato possibilie memorizzare e manipolare data set di tali dimensioni all'interno di un sistema single-memory.

Nelle intenzioni dell'azienda di Palo Alto, questa è solo un'anteprima delle potenzialità del calcolo in-memory basato su The Machine. Sulla base del prototipo attuale, Hpe prevede che l'architettura possa facilmente scalare fino a sistemi single-memory di scala exabyte e, andando oltre, fino a un pool di memoria pressoché infinito (4.096 yottabyte, cioè mille volte la dimensione dell'universo digitale odierno). “Siamo convinti che il memory-driven computing sia la soluzione per far progredire il settore in modo da consentire passi avanti in tutti gli aspetti della società”, ha commentato Mark Potter, chief technology officer di Hpe e direttore degli Hewlett Packard Labs. “L'architettura che abbiamo presentato può essere applicata a qualsiasi categoria informatica, dai dispositivi edge intelligenti fino ai supercomputer”.