Il timore che l'intelligenza artificiale possa diventare uno strumento di morte esiste, inutile negarlo. Alla quella che un tempo era la corsa agli armamenti ora si è sostituita, nella strategie militari degli Stati, una corsa all'algoritmo, al robot-soldato, al drone equipaggiato con capacità di analytics video che gli permettono di riconoscere un oggetto a distanza. Google ha scelto di uscire dall'ambiguità prima che fosse tardi, scegliendo di non rinnovare l'impegno in Project Maven ma senza rinunciare ad altre collaborazioni con governi e forze militari, come sottolineato dall'amministratore delegato Sundar Pichai.

Di certo l'intelligenza artificiale sta dimostrando di essere uno strumento potente, potenzialmente pericoloso (se usato a fini offensivi) ma anche amico della sicurezza e della legalità. Un esempio è il sistema sperimentale sviluppato a sei mani da tre ricercatori dell'Università di Cambridge, del National Institute of Technology di Warangal, India, e dell'Indian Institute of Science di Bangalore: i suoi ingredienti sono i droni, la videosorveglianza, un software basato su algoritmi di deep learning (una declinazione dell'intelligenza artificiale basata su schemi di ragionamento gerarchici) e il cloud, oltre a un bel po' di matematica.

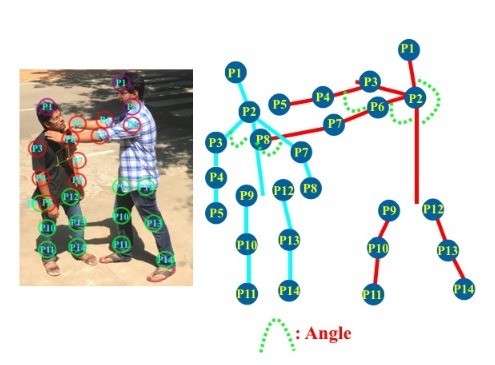

Il team del progetto ha allenato un particolare algoritmo di apprendimento automatico per renderlo capace di identificare nelle immagini catturate da una videocamera (in questo caso, quella di un drone) azioni violente come calci, pugni, pugnalate e l'atto di sparare. Per il training è stato impiegato un archivio di circa duemila immagini raffiguranti migliaia di persone intente a compiere o subire atti di violenza.

Il software analizza i filmati nel cloud, potendo quindi soddisfare con facilità le elevate esigenze di calcolo e di memoria richieste dalle applicazioni in cui si uniscono contenuti video e machine learning. I comportamenti violenti vengono riconosciuti in tempo reale sulla base di posizioni, distanze e movimenti, e svengono egnalati visivamente dal software in un modo molto efficace: sulla schermata del filmato, l'autore del gesto si colora di linee rosse, mentre gli altri sono indicati in blu.

Quanto è preciso questo sistema, ancora sperimentale? L'accuratezza dipende dalla tipologia di gesto da riconoscere e potrà essere elevata in futuro ampliando la base di dati del training. Per il momento si è già raggiunta un'accuratezza del 94%, percentuale che scende al 79% nel caso la scena sia occupata da più di dieci soggetti. Non male come inizio, specie considerando che un sistema di questo tipo potrebbe essere affiancato a un'opera di supervisione umana per controllare luoghi pubbici, stazioni, aereoporti, stadi e quant'altro, senza necessariamente affidare l'intera responsabilità all'intelligenza artificiale ma usandola come strumento di allerta.