Il nuovo paradigma di Hpe ha fatto un altro passo avanti. L’azienda, durante l’evento Discover 2016 di Londra, ha presentato il primo prototipo realmente funzionante di The Machine, progetto a cui sta lavorando da almeno un paio di anni e che sposta il focus sul cosiddetto memory-driven computing: vale a dire l’elaborazione incentrata sulla memoria e non più sui processori. Un’iniziativa ambiziosa, su cui Hpe sta investendo molto e che il vendor non manca puntualmente di ricordare con diversi annunci sparsi qua e là. Ma, questa volta, sembra che The Machine sia uscita dalla prima fase embrionale e sia pronta a dimostrare tutto il proprio valore. La soluzione di Hpe unisce la potenza dell’elaborazione in-memory (quindi ad altissima velocità) a connettori fotonici/ottici che permettono lo scambio di informazioni a velocità nettamente maggiori rispetto a oggi.

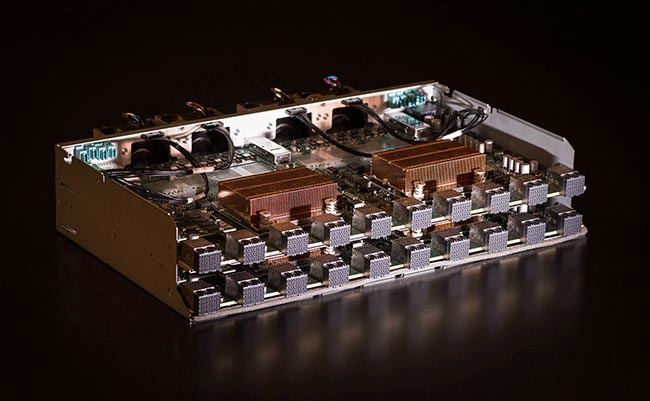

Il proof-of-concept, “acceso” a ottobre, mette in mostra il lavoro congiunto dei blocchi fondamentali della nuova architettura, vale a dire i nodi di elaborazione in grado di accedere tramite fabric alle risorse di memoria e, come detto, i link fotonici (tra cui il nuovo modulo X1). A governare il tutto c’è un sistema operativo basato su Linux, ma sviluppato ad hoc per The Machine, eseguito su un system-on-chip (Soc) customizzato.

L’ecosistema, chiamato nella versione provvisoria Linux++ (il nome definitivo dovrebbe essere Carbon), è stato presentato a fine 2014 e da allora gli sviluppatori stanno testando i propri applicativi compatibili con la piattaforma all’interno di un ambiente di simulazione, capace di riprodurre il design di The Machine.

Per facilitare la vita degli sviluppatori che per primi potranno testare la soluzione di Hpe, il vendor inizierà a mettere a disposizione anche nuovi strumenti di programmazione che permetteranno di sfruttare al massimo la memoria persistente della “Macchina”. Sì, perché il progetto del colosso californiano è basato in larga parte sulle innovazioni tecnologiche garantite dai memristori.

Definiti già negli anni Settanta come il “quarto elemento” base di un circuito, questi componenti riescono a unire funzioni di memorizzazione e di resistore, sostituendo così i transistor che, per loro natura, non possono conservare le informazioni una volta interrotto il flusso di corrente elettrica.

Hpe ha spiegato che i primi test condotti con The Machine hanno portato a un’elaborazione di codice ottomila volte più veloce rispetto ai Pc di oggi. Ma, per liberare effettivamente tutte le potenzialità dei sistemi, sarà necessario aggiungere nuovi nodi. Per non parlare della produzione a volume dei memristori, che potrebbe iniziare non prima del 2019.

Ma, una volta chiuso il cerchio, gli scenari potenziali saranno certamente esaltanti. Le soluzioni che deriveranno da The Machine (è improbabile infatti che Hpe decida di mettere sul mercato la piattaforma come blocco unico) potranno prestarsi senza sforzo all’elaborazione e all’analisi dei Big Data e del “diluvio” di informazioni che caratterizzerà l’Internet delle Cose. Il gruppo guidato da Meg Whitman sta comunque già applicando ad alcuni prodotti in commercio le prime innovazioni tecnologiche derivanti dalla sperimentazione.

Per esempio, alcuni modelli di server Proliant sono stati aggiornati di recente con componenti di memoria persistente, provenienti proprio dallo sviluppo di The Machine. I moduli sono integrati in un form factor Nvdimm (non-volatile dual in-line memory module), che offre alle appliance una velocità di elaborazione dei database quattro volte più veloce rispetto alla generazione “standard”. L’anno prossimo, invece, dovrebbero essere lanciati i primi sistemi Synergy con componenti ottici.