Quanto sono grandi i Grandi Dati in Italia? Il fenomeno Big Data, legato a doppio filo con gli analytics e la Business Intelligence, è tra le aree tecnologiche più in fermento nelle aziende del mondo, e quelle tricolori non fanno eccezione: pur in un anno di generale contrazione dei budget Ict, a -4% rispetto al 2012, la spesa per sistemi di Big Data Analytics e di Business Intelligence è cresciuta del 22% nelle organizzazioni italiane di grandi dimensioni. Lo afferma una ricerca condotta dall’Osservatorio Big Data Analytics & Business Intelligence della School of Management del Politecnico di Milano.

Un'infografica di Ibm rende l'idea del boom dei dati atteso nei prossimi anni

In questa sua prima edizione, l’indagine ha coinvolto

184 imprese e Pubbliche Amministrazioni con due survey indirizzate a chief information officer e chief marketing officer, 30 approfondimenti con interviste dirette e casi di studio, e infine tre workshop tematici per validarne i risultati. Risultati dalla doppia anima: da un lato, risultano in crescita un po’ tutte le attività che ruotano intorno ai dati – la loro raccolta, analisi, il monitoraggio dei social e quindi la valutazione delle forme non strutturate di informazione, e ancora l’intelligenza predittiva – ma dall’altro in meno di un caso su cinque (19%) si può già parlare, a rigore, di Big Data. La sensazione è quella di essere su una strada inevitabilmente da percorrere (pena il rischio di non essere competitivi, per le aziende, e di rimanere nel secolo scorso per le amministrazioni pubbliche), ma ancora nel primo tratto di questo percorso.

Come si diceva, la propensione alla

spesa in tecnologie di trattamento dei dati è più alta della media degli investimenti in Ict. Il 42% dei Cio intervistati ha detto di voler aumentare la propria capacità di spesa per i sistemi di Big Data Analytics e di Business Intelligence, rispetto al 14% che intende rivederla al ribasso; la maggior parte del budget si concentra sull’acquisto di licenze software (32%), di servizi di integrazione (31%) e di hardware (storage, server e networking, 34%), mentre soltanto un 3% viene dedicato ai servizi cloud, per i quali l’interesse è comunque in crescita.

Ma che cosa fanno, le aziende, con i dati? Già oltre i tre quarti di quelle prese in considerazione dall’Osservatorio, il

76%, esegue analisi passive utilizzando

sistemi di Performance Management & Basic Analytics, e a queste va aggiunto un 6% che dichiara di averne pianificato l’introduzione (il 14% è in fase di valutazione, il 4% non è interessato); le funzionalità più utilizzate sono i servizi di query e reporting, seguiti da analisi Olap e cubi dimensionali (57%), dashboard e scorecard (55%) e sistemi di alerting (39%).

Più acerba è l’adozione di tecnologie predittive, come gli

Advanced Analytics, che consentono di gestire processi decisionali complessi o di determinare trend futuri attraverso modelli matematici di forecasting, statistica, data mining e ottimizzazione: attualmente, i sistemi che eseguono analisi avanzate sono sfruttati dal 36% delle organizzazioni, con un ulteriore 27% di realtà in una fase di valutazione. Nel dettaglio, la funzionalità più utilizzata è quella di data mining (27%), seguita dal forecasting (25%) e dai modelli di ottimizzazione (11%).

Per quanto riguarda invece non le tecnologie, bensì le

funzioni di business che ne beneficiano, in testa c’è l’area commerciale (nel 73% dei casi), seguita da programmazione e controllo (61%), poi da finance (59%), marketing/comunicazione (57%), direzione generale (57% ) e amministrazione (56%), logistica (43%), acquisti (39%), produzione (37%) e risorse umane (36%), mentre solo nel 16% delle risposte è stata segnalata la divisione ricerca & sviluppo.

“L’analisi dei Big Data offre innumerevoli potenzialità a imprese di qualsiasi comparto”, ha commentato

Carlo Vercellis, responsabile scientifico dell'Osservatorio, “ma la gestione delle enormi quantità di dati oggi disponibili pone le aziende di fronte a molteplici sfide. Da un lato, occorre predisporre i sistemi di Big Data Analytics alla memorizzazione di volumi crescenti di informazioni e alla trasformazione e integrazione di dati di diversa natura. Dall’altro, occorre comprendere come sfruttare le potenzialità dei Big Data e farne un uso strategico in base alla propria tipologia di business. I progetti di BDA & BI richiedono una governance coordinata per permettere di raggiungere benefici quantificabili e di lungo periodo”.

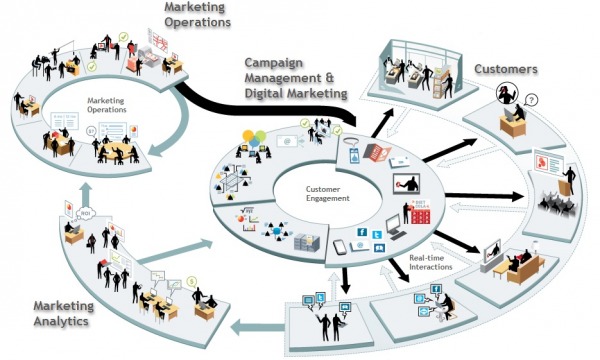

L'area marketing e comunicazione è fra quelle che più sfruttano gli analytics (immagine di Teradata)

“Oggi esiste un’ampia offerta di sistemi di Big Data Analytics e si è allargata la platea dei potenziali fruitori, grazie alla maggiore usabilità delle soluzioni tecnologiche e la pervasività dei dispositivi mobili”, spiega

Alessandro Piva, responsabile della ricerca. “Crescono così le possibilità di utilizzo e gli ambiti di progetto, e aumentano le competenze richieste a nuove figure di data scientist: non servono solo skill informatiche, statistiche e di processo, ma anche capacità di demand management nei confronti delle line of business, di interpretazione dei dati e delle analisi prodotte”.

Da tutto questo scenario, certamente complesso e non più tanto acerbo, emerge comunque una considerazione: ai veri Grandi Dati la maggioranza delle aziende e delle organizzazioni pubbliche ancora non è arrivata. Tanto più se si considera il fatto che la ricerca del Politecnico di Milano ha coinvolto realtà di dimensioni superiori alla media. Certamente i volumi di dati che entrano ed escono dai sistemi di analytics e di Business Intelligence sono in crescita, sia per quando riguarda i dati strutturati (+19% sul 2012), sia per quelli destrutturati (+28%).

A rigore, nell'

espressione “Big Data” dovrebbero rientrare solo quelle masse di dati caratterizzati da volume, velocità, varietà, e varietà; in cui la quantità è tale da rendere inefficiente il ricorso a database

tradizionali e da richiedere sistemi di memorizzazione scalabili; in cui è elevata la frequenza di aggiornamento e la rapidità in cui sono memorizzati, storicizzati ed elaborati; in cui le fonti sono molto eterogenee per origine, contenuto e rappresentazione. Stando a questa definizione, ancora meno di un quinto, il

19%, delle aziende italiane può già dire di farne uso nei propri sistemi di analisi e di Business Intelligence.