Ziya Aral parla dello storage definito dal software in termini molto semplici, definendolo come un modo per separare, o astrarre, il livello hardware da quello software. Una cosa che la sua azienda, DataCore Software, fa da molti anni, da molto prima che “storage definito dal software” diventasse un termine di uso comune. Aral è uno dei fondatori di DataCore, e oggi ne è il presidente del consiglio di amministrazione. In questa chiacchierata, Aral espone il suo punto di vista su questo argomento “caldo”, affrontando in particolare il tema dei dischi a stato solido (SSD) e della loro integrazione nell’infrastruttura di storage.

Ziya Aral è stato uno dei fondatori di DataCore Software e oggi ne è presidente del consiglio di amministrazione.

“

E’ la velocità a rendere gli SSD importanti,” dice riferendosi a questa tipologia di dispositivi. “

Nella storia informatica, storage ha quasi sempre significato dischi. E i dischi sono meccanici, quindi lenti. Per aumentarne la velocità si è fatto ricorso a un sacco di complicati espedienti, come lo sfruttamento delle cache o altri trucchetti. Poi all’improvviso sono comparsi gli SSD, che possono essere utilizzati in modo trasparente, esattamente come i dischi tradizionali: è sufficiente togliere un’unità di tipo convenzionale e sostituirla con una di nuovo tipo e tutto diventa più veloce. Qualunque sistema operativo si faccia partire, da Windows a Linux, bastano pochi secondi. Incredibile. Tutto questo dimostra quanto sia importante uno storage veloce.”

Questo è il punto di arrivo della tecnologia per l’archiviazione dei dati, che in passato non ha mostrato altrettante doti prestazionali. “

Lo storage è la pecora nera dell’informatica,” dice Aral. “

La sua tecnologia è sempre rimasta un passo indietro, a causa della sua natura meccanica: è l’elemento che rallenta l’esecuzione delle applicazioni. Una volta circa un terzo di tutte le applicazioni aveva esigenze di storage, mentre oggi probabilmente siamo al 95 per cento. E mentre tutto è diventato più veloce, lo storage non lo ha fatto. Per questo qualunque innovazione in grado di aumentare la velocità dello storage è benvenuta, e gli SSD lo fanno in modo pratico ed economicamente abbordabile. Questa è la buona notizia. Quella cattiva è che in realtà gli SSD non funzionano proprio come i dischi tradizionali: sono più complicati.”

Non si tratta di complicazioni dal punto di vista meccanico, visto che gli SSD non hanno parti in movimento, quanto di limiti legati alla tecnologia delle memorie a stato solido. “Se la lettura dei dati su SSD è un’operazione estremamente veloce, la loro scrittura non lo è altrettanto,” spiega Aral. “E quel che è peggio, è che agli SSD la fase di scrittura non piace per nulla. Mi spiace per i miei amici che lavorano in quel settore, ma che è così lo sappiamo tutti: gli SSD hanno una vita utile abbastanza breve, rispetto agli standard a cui siamo abituati con i dischi tradizionali. Ecco da dove nasce la complessità. Gli SSD non sono adatti a qualunque impiego e cono ancora costosi per diventare il sistema di storage primario. E’ quindi indispensabile riflettere su come utilizzarli, specialmente nelle architetture più grandi.”

Il software è la chiave per sfruttare al meglio la tecnologia SSD.

Questa riflessione non è (ancora) alla portata di tutti: richiedi sforzi di ideazione e sviluppo che non sono legati specificamente al funzionamento base di un disco a stato solito, ma piuttosto al suo ottimale sfruttamento in ambienti produttivi aziendali. “

Oggi in questo settore ci sono persone molto brillanti, persone come quelle che lavorano in Fusion-io, con cui stiamo cercando di lavorare,” afferma Aral. “

Sono concentrate sull’utilizzo degli SSD in applicazioni specifiche, in questo caso i database, abbinandoli a due tecnologie per aiutarli a superare i loro limiti. Una è il software, tramite il quale si occupano di gestire le tecniche di caching, l’altra è la DRAM. Questo tipo di memoria ha il vantaggio di non porre limiti al numero di operazioni di scrittura.”

Ecco quindi che l’importanza di avere uno storage definito dal software emerge con grande chiarezza.

Il software, infatti, è la chiave per sfruttare al meglio la tecnologia SSD. “

Far lavorare i dischi mantenendo costante la disponibilità delle applicazioni non è cosa da poco e l’intero mercato della virtualizzazione dei server sembra essersi cristallizzato intorno alle applicazioni di primo livello e ai desktop virtuali,” dice Aral. “

Ora però è arrivata questa grande tecnologia di storage, complementare a quella dei dischi più tradizionali, ma capace di cambiare le cose in modo rilevante. Integrata con la DRAM sembra funzionare, ma questo sta cambiando gli schemi con cui abbiamo lavorato per anni e anni.”

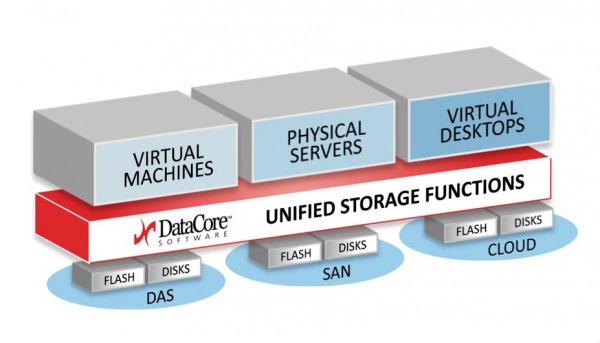

Cambiare gli schemi significa cominciare a pensare di non potersi più affidare esclusivamente al software che accompagna i sistemi di storage. “Per esempio, per trarre il massimo vantaggio dagli SSD bisogna che questi si trovino sulla stessa macchina in cui risiede l’applicazione,” afferma Aral. “La maggior parte degli SSD funziona così. Ora si sta cercando di realizzare batterie di dischi ibridi e batterie completamente basate su SSD, ma così il rischio è quello di perdere i benefici. Ci sono limiti fisici nella trasmissione dei dati via cavo, e in questo processo molto del vantaggio degli SSD sparisce. Il risultato è che oggi stiamo cercando di capire come spostare gran parte dell’infrastruttura software per lo storage sui server e sulla rete.”

Lo storage definito dal software permette di superare i limiti della tecnologia SSD.

L’esigenza di spostare il software su macchine remote

nasce dal tentativo di evitare, o di ridurre, le operazioni di scrittura sui dischi a stato solido. Per agevolare il loro compito, bisogna ragionare su un tempo di latenza molto lungo, e questo significa che i dati devono trovarsi contemporaneamente in almeno due luoghi diversi, e che quindi devono essere spostati via cavo.

“I due estremi del ciclo - le operazioni di lettura dirette e quelle di scrittura asincrone - avvengono in due luoghi diversi,” conferma Aral. “

Il software che permette di tenere insieme queste due fasi deve quindi trovarsi a entrambi i capi del cavo. In pratica, bisogna essere in grado di scrivere i dati in remoto e di leggerli localmente, ovvero di dividere i dati e i relativi dispositivi. La comunicazione tra questi ultimi, posizionati in rete e localmente, deve avvenire utilizzando un bridge software. Per questo il software deve trovarsi in entrambe le postazioni.”

Attraverso il software si risolve così il problema dei cicli di scrittura sui dischi allo stato solido. Ovviamente si tratta di software che deve stare sulle macchine che gestiscono l’infrastruttura, non sui sistemi di storage. E tra i suoi compiti c’è anche quello di organizzare l’ambiente in modo che i dati provengano dalla DRAM, che è molto più veloce degli SSD. In questo modo lo storage definito dal software permette di superare i limiti di una tecnologia che altrimenti sarebbe rimasta confinata a poche, specifiche applicazioni.