Apple svela per la prima volta alcuni dei suoi segreti nel campo dell'intelligenza artificiale. Un tema non certo sconosciuto a Cupertino: grazie al machine learning funzionano, per esempio, l'assistente virtuale di iOS, Siri, ma anche la nuvola di iCloud, il marketplace di iTunes e altri servizi futuri come quelli delle automobili driverless. Forse in modo meno eclatante rispetto alla concorrenza (su tutti Microsoft, arrivato a dedicare a questo filone un'intera business unit con cinquemila collaboratori), anche la società di Cupertino sta compiendo investimenti in questo campo, senza disdegnare le acquisizioni di aziende specializzate. La novità è che ora, per la prima volta, alcuni ricercatori ed esperti affiliati ad Apple hanno pubblicato uno studio che indirettamente lascia capire quali siano le specifiche tecnologie indagate e sfruttate dalla casa madre dell'iPhone.

Nel documento, titolato “Learning from Simulated and Unsupervised Images through Adversarial Training”, i ricercatori Ashish Shrivastava, Tomas Pfister, Oncel Tuzel, Josh Susskind, Wenda Wang, Russ Webb illustrano alcuni risultati raggiunti nell'applicazione del machine learning allo studio delle immagini. E in particolare si parla di una tecnica con cui è possibile sostituire fotografie di oggetti reali con “immagini sintetiche” create da un computer.

Le immagini sintetiche vengono impiegate (non solo da Apple) nelle attività di “allenamento” delle reti neurali artificiali, che da questi esempi imparano a riconoscere e catalogare oggetti, acquisendo via via una capacità interpretativa applicabile poi a situazioni reali. Il vantaggio di questo tipo di contenuto è che non è necessario aggiungere manualmente annotazioni e tag, cioè attributi verbali utili per l'indicizzazione; lo svantaggio è che spesso la complessità del mondo reale non può essere ricondotta totalmente a queste rappresentazioni artificiali.

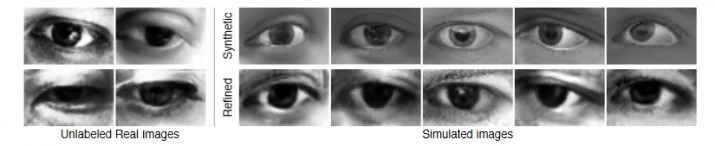

Esiste dunque uno scarto fra le immagini catturate da una macchina fotografica o da una videocamera e quelle sintetiche, perché queste ultime risultano inevitabilmente troppo perfette, uniformi, non credibili. Un'applicazione di intelligenza artificiale “educata” a riconoscere solo immagini sintetiche potrebbe non lavorare bene una volta calata nella realtà. Ed è qui che si inserisce il lavoro dei ricercatori di Apple: per ridurre il gap tra le immagini sintetiche e quelle autentiche, è stato sviluppato un metodo che prende le mosse dall'esistente algoritmo Generative Adversarial Networks (Gan), modificandolo, e che utilizza due diverse reti neurali operanti in sinergia ma anche, in un certo senso, in competizione fra loro.

Il sistema si compone di due parti: “generatore”, cioè un programma che tenta di creare immagini simili a quelle (non sintetiche) presenti in dataset di partenza; e un “classificatore”, incaricato di distinguere quali immagini siano frutto del computer e quali catturate dalla realtà. L'intelligenza artificiale istruita sulla base di questo sistema risulta più abile nel sovrapporre le creazioni sintetiche dalle fotografie genuine. Dunque, anche qualora allenata con immagini sintetiche (con il vantaggio dei tag automatici), un'applicazione saprà riconoscere bene i soggetti fotografati o inquadrati con la fotocamera di uno smartphone. Il meccanismo funziona anche al contrario, ovvero il generatore di immagini sintetiche impara ad aggiungere delle "imperfezioni" che rendono più realistico il risultato. Al momento Apple sta mettendo alla prova il sistema nello studio delle immagini statiche, ma in futuro estenderà la ricerca al campo dei video.