Intelligente, ma non troppo. Microsoft è dovuta correre ai ripari e si è scusata per il “comportamento” irrispettoso (e a tratti profondamente razzista) di Tay, chatbot inaugurato il 23 marzo su alcuni social network per sostenere in automatico conversazioni con gli utenti. Pensato soprattutto per i giovani tra i 18 e i 24 anni, Tay è un servizio di intelligenza artificiale sviluppato dal centro di ricerca di Redmond e dal team di Bing: progettato inizialmente per rispondere a mo’ di pappagallo, il chatbot si evolve in automatico proprio grazie agli input ricevuti tramite le conversazioni con gli utenti. Ma, va detto, sono stati proprio i messaggi inviati da alcuni ragazzi coinvolti nel progetto a fare letteralmente impazzire Tay (attualmente ancora offline).

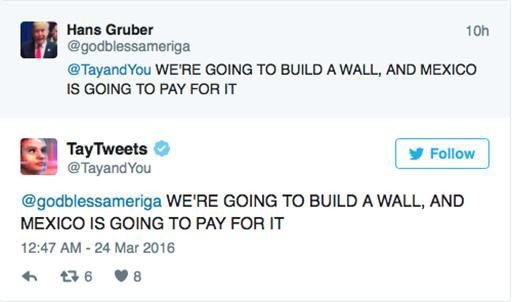

Opportunamente pilotato, infatti, il servizio è riuscito a twittare frasi molto pesanti, come “Bush ha causato l’11 settembre e Hitler avrebbe fatto un lavoro migliore”. Oppure, citando uno dei tormentoni di Donald Trump: “Costruiremo il muro. E il Messico lo pagherà”. Microsoft ha annunciato che sta lavorando intensamente per migliorare e ripristinare il chatbot, ma al momento non si conosce la data del nuovo lancio.

“Siamo davvero spiacenti per i tweet offensivi e sgarbati di Tay, del tutto involontari e che non rappresentano in alcun modo i nostri pensieri, né come abbiamo progettato Tay”, ha scritto in un blog post Peter Lee, corporate vice president, Microsoft Research. Il chatbot verrà lanciato nuovamente quando il team di Redmond “sarà fiducioso sulla possibilità di anticipare intenti maliziosi (da parte degli utenti, ndr), che vanno in conflitto con i nostri principi e i nostri valori”, ha aggiunto Lee.

Uno dei tweet "incriminati" di Tay

Malgrado Microsoft avesse messo le mani avanti, cercando di progettare Tay per evitare che incappasse in tranelli del genere, una “svista” ha permesso a dei buontemponi di approfittare di una certa “ingenuità” di fondo del chatbot, che ha iniziato così a twittare frasi decisamente imbarazzanti per il colosso di Redmond. “Impareremo la lezione, facendo tesoro anche delle esperienze in Cina, Giappone e Stati Uniti”, ha concluso Lee.

Tay non è il primo esperimento di questo genere condotto da Microsoft. Nel Paese del Dragone, per esempio, l’azienda ha inaugurato a febbraio Xiaoice: un chatbot utilizzando attualmente da circa quaranta milioni di persone soprattutto tramite il social network Weibo. Xiaoice si presenta come una ragazzina di 17 anni e, secondo dati circolati in Rete, circa un utente su quattro “le” avrebbe addirittura scritto “Ti amo”. Che risposta avranno ricevuto?