L’intelligenza artificiale dovrà essere “aperta”, sicura, flessibile e, per così dire, collettiva. La promessa fatta da Red Hat ad aziende, partner e sviluppatori è la stessa portata avanti da decenni nell’ambito del DevOps e del cloud ibrido, ispirata ai medesimi principi della collaborazione, dell'open source e dell’assenza di lock-in. “Vogliamo ripetere in ambito AI ciò che è stato fatto negli ultimi trent’anni con tutti i prodotti da noi veicolati sul mercato”, ha sintetizzato Gianni Anguilletti, vicepresidente per la regione mediterranea di Red Hat, in occasione di un recente incontro con la stampa.

Gli ha fatto eco Giorgio Galli, head of presales per l’Italia: “In Red Hat il tema dell’AI si affianca alla strategia esistente, che è sempre stata quella di lavorare nell’open source e nel cloud ibrido, con una tecnologia che possa funzionare sull’infrastruttura sottostante che meglio si adatta alle esigenze delle aziende, e con un disaccoppiamento dalla parte applicativa sovrastante. Il tema ora è passare dalla virtualizzazione, tecnologia ancora importante ma che non ha un’evoluzione, alla containerizzazione. Il mantra è cloud-native, cioè avere architetture scalabili, guidate da eventi, per supportare nuove applicazioni e servizi. Questo include l’edge e i workload di intelligenza artificiale”.

Le tecnologie si evolvono, quindi, ma i principi ispiratori di Red Hat restano gli stessi. E questa strategia continua a dare ottimi frutti: “In Italia cresciamo a doppia cifra e più del mercato, trasversalmente a tutti i settori”, ha dichiarato il country manager, Rodolfo Falcone. “In particolare, energia e utility stanno spingendo moltissimo, il settore è diventato frizzante e competitivo. Il mondo finance è sempre molto in crescita e ha una visione internazionale”.

Per Red Hat la rivoluzione dell'AI si innesta su altre trasformazioni ancora in corso e che si stanno rimodellando, come la transizione verso il cloud. “Red Hat gestisce la digitalizzazione delle più importanti aziende italiane, come Poste Italiane, Sogei, il governo italiano” ha proseguito Falcone. “Negli ultimi anni ho visto un’accelerazione incredibile nella digitalizzazione, anche grazie al Pnrr. C’è stata una spinta verso un modello open anche in settori come telecomunicazioni, automotive e manifatturiero. Ora stiamo vedendo non più una migrazione totale in cloud, perché i clienti si sono accorti che questo costerebbe dieci volte tanto”.

Rodolfo Falcone, country manager, Gianni Anguilletti, vicepresident Mediterranean Region, e Giorgio Galli, head of presales Italy di Red Hat

Da parte della propria clientela Red Hat sta osservando, invece, una scelta di migrazione selettiva di alcune attività in cloud, e non quindi un abbandono totale dell'on-premise. “Tutte le aziende che vediamo seguono questo modello business con, in più, una spolverata di AI”, ha spiegato il country manager. “L’Ai rende i processi più intelligenti ma il problema oggi è capire quale informazioni farle digerire, perché il risultato che l’AI produce non è che il prodotto delle informazioni che le vengono date in pasto. L’obiettivo di Red Hat è aiutare i clienti ad avere nella creazione ed esecuzione di applicazioni di AI la stessa disciplina e rigore che hanno per il DevOps e il DevSecOps”.

Per aiutare i clienti in questo, Red Hat non propone applicazioni di intelligenza artificiale fatte e finite, ma da un lato sta integrando capacità di GenAI all’interno della propria offerta e dall’altro si rivolge agli sviluppatori con nuovi strumenti per la creazione di modelli e applicazioni. Sul primo fronte, ha debuttato la tecnologia Lightspeed per Ansibile, ovvero una sorta di copilota conversazionale che aiuta gli sviluppatori a creare contenuti su Ansible in modo più efficiente (per esempio, con capacità di scrittura automatizzata di codice). Questa tecnologia debutterà prossimamente anche su OpenShift (per aiutare nella gestione del cluster) e su Red Hat Enterprise Linux.

Molti degli annunci fatti durante il summit di Denver ruotano intorno al tema dell’AI: dalle collaborazioni con Intel (il continuo supporto per i nuovi chip) e Nvidia (i cui microservizi possono essere eseguiti sulla piattaforma di Red Hat) a quelle con Amd ed Elastic (database vettoriale utilizzabile per il fine-tuning), e ancora la tecnologia Run:AI (che permette di schedulare le necessità hardware per il bilanciamento del carico nel training e nell’esecuzione dei modelli), e un accordo con Deloitte, Qualcomm, Renesas nell’ambito dei software per il settore automobilistico (per supportare il ciclo di sviluppo e testing per i veicoli software-defined). Inoltre è stato annunciato che le oltre cento aziende del consorzio AI Sweden utilizzeranno OpenShift AI per le proprie attività di ricerca.

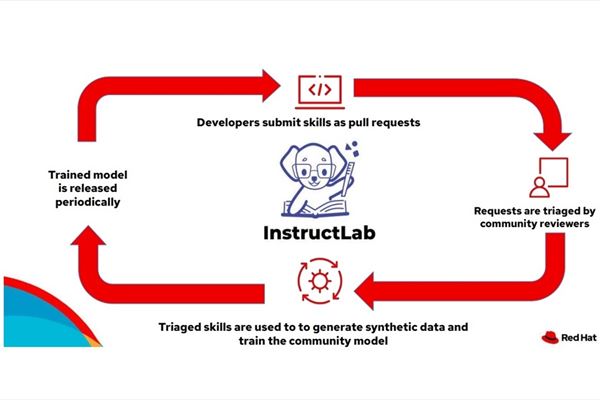

Una delle novità su cui Red Hat scommette maggiormente è InstructLab, un progetto rivolto alla community degli sviluppatori: si tratta di una metodologia con cui è possibile modificare i large language model, eventualmente condividendo poi tali migliorie con la community ma solo nel caso siano state validate dalla collettività. In sostanza, è possibile allenare i modelli inclusi in InstructLab (al momento in catalogo disponibile Ibm Granite, ma ne seguiranno altro) con ulteriori dati e domande, per esempio focalizzandosi su un certo argomento o ambito settoriale; il software crea poi dei dati sintetici, cioè una serie di domande e risposte aggiuntive derivate da quelle esistenti; le modifiche effettuate vengono sottoposte alla community per un triage e, se accettate, possono essere condivise. La sottostante infrastruttura per il training viene messa a disposizione da Ibm.

“A Denver”, ha raccontato Anguilletti, “su 5.000 aziende partecipanti al summit, puntavamo ad avere un 10% che chiedesse informazioni o provasse lo strumento nel nostro stand. Sono stati 3.000, a dimostrazione del grande interesse che esiste sull’AI generativa”.

Altra novità è Red Hat Enterprise Linux AI, una piattaforma software che permette di creare, distribuire, monitorare e utilizzare modelli e applicazioni di intelligenza artificiale, potendo contare sul supporto della community open source. La piattaforma mette insieme diversi large language model della famiglia di Granite e gli strumenti del progetto InstructLab, utili per il loro miglioramento e per la validazione allargata nella community.

Su un gradino sopra si pone OpenShift AI, piattaforma ibrida per le operazioni di machine learning (MLOps), adatta per quelle aziende o sviluppatori che debbano eseguire più modelli di AI e disporre di maggiore scalabilità. “OpenShift AI”, ha spiegato Galli, “è una componente importante perché permette di gestire il ciclo di vita dei modelli di AI generativa, dallo sviluppo al rilascio del servizio, e anche di esporre il servizio ad applicazioni terze che fanno uso di un modello”.