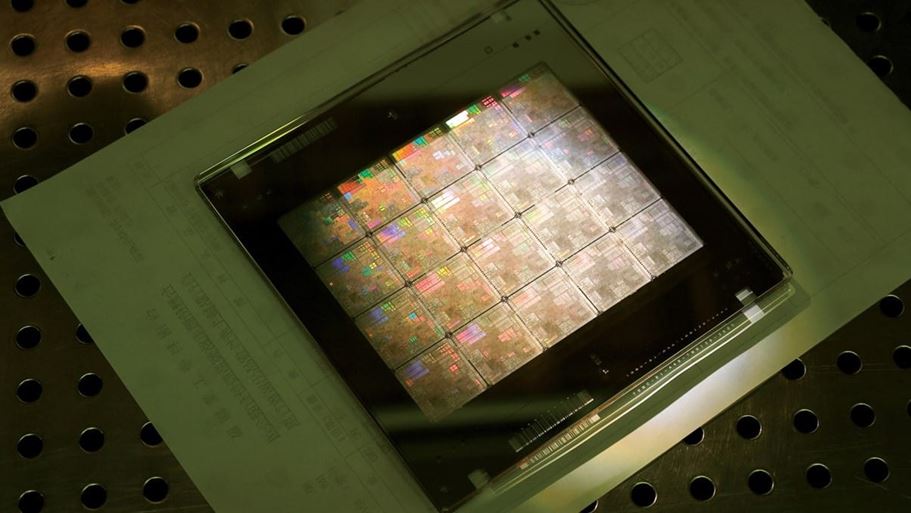

Un chip di Tsmc che utilizza la tecnologia di Nvidia

Una intelligenza artificiale sempre più “umana”, capace di ragionare come un cervello: questo è, per molti, il destino che attende l’AI, e con lei il mondo intero. Ma questa prospettiva non sarà sostenibile su larga scala se i costi del computing non caleranno. Così la pensa Jensen Huang, amministratore delegato di Nvidia, come espresso durante un podcast condotto dal Ceo di Arm, Rene Haas.

In futuro, l’AI sarà alla base di servizi capaci di “ragionare”, ma per uno sviluppo di questo tipo sarà necessario innanzitutto abbassare i costi dell’elaborazione dati. A tendere, il problema della sostenibilità economica dell’intelligenza artificiale potrebbe diventare più rievante. Al crescere della sofisticazione e della capacità dei modelli aumentano anche le loro dimensioni, cioè la quantità di dati usati per il training, i miliardi di parametri considerati, così come i requisiti del processore e i consumi energetici associati.

Ma Huang è ottimista. Queste le sue parole, riportate da Bloomberg: “Abbiamo la capacità di favorire una incredibile riduzione di costi per l’intelligenza. E il valore è chiaro per tutti. Se possiamo ridurre enormemente i costi, potremo eseguire attività come il ragionamento alla velocità dell’inferenza”.

Nvidia detiene attualmente oltre il 90% di market share nel settore degli acceleratori di AI, ovvero microprocessori specializzati per attività come il machine learning, il deep learning, la visione computerizzata e la generazione di contenuti. Durante la conferenza in corso a Washington, l’AI Summit 2024, l’azienda ha presentato un blueprint per la cybersicurezza dei container e ha annunciato che la propria tecnologia di litografia computazionale cuLitho (una libreria di algoritmi e strumenti basati su Gpu) verrà usata da Tsmc per accelerare la produzione di semiconduttori.