Adottare l’intelligenza artificiale in azienda significa fare delle scelte sui fornitori di software e servizi, sui large language model a cui affidarsi, sulla base di dati da utilizzare per il training o il fine-tuning dei modelli. Se questo è noto, è forse meno immediato pensare che l’AI comporti anche delle scelte di infrastruttura. Dove reperire la capacità di calcolo necessarie per attività di training o inferenza, dove custodire i dati prodotti dall’AI o quelli che la alimentano? In cloud o dentro i confini dell’azienda, o un mix delle due cose? Idc lo ha chiesto a 600 decisori IT di aziende dell’area Emea, tra cui una cinquantina di italiani, nell’ambito di un’indagine commissionata da Lenovo e condotta nel mese di febbraio (dal titolo "Cio Playbook 2024. It's all About Smarter AI").

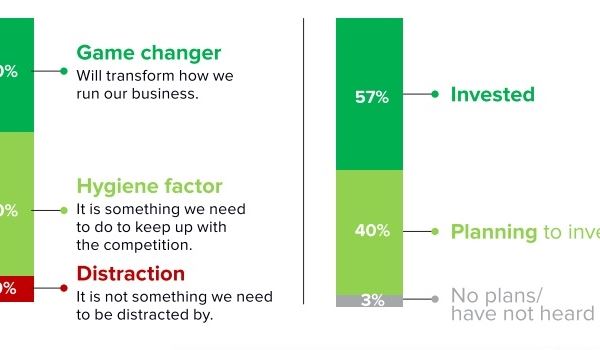

Solo il 10% delle organizzazioni la vede come qualcosa di non rilevante, come una distrazione, mentre il restante 90% oscilla tra il considerarla un "fatto di igiene", cioè qualcosa di necessario per restare competitivi (50% degli intervistati) o addirittura un vero punto di svolta per il business, un “game changer” (40%). In Italia, peraltro, la quota dei decisori IT non interessati scende al 2%, uno tra i dati più bassi in Emea mentre il 40% la considera un punto di svolta e il 50% pensa sia necessario adottarla per non perdere terreno nel proprio mercato di riferimento.

Il 57% delle realtà del campione ha già investito in AI e un ulteriore 40% prevede di farlo nel corso dell’anno, mentre appena il 3% non ha intenzione di attivare progetti di AI. In media, la spesa delle aziende Emea in intelligenza artificiale dovrebbe crescere del 61% quest’anno rispetto ai livelli del 2023, e il dato è grossomodo in linea con quello delle nordamericane (+62%). L’interesse è rivolto verso l’AI generativa, oggi in pieno boom, che dovrebbe attrarre quest’anno circa il 24,7% degli investimenti aziendali in intelligenza artificiale. Il resto andrà ad altre forme di machine learning (24,9% di investimenti) al deep learning per applicazioni di intelligenza artificiale interpretativa (25,4%) e alla robotica (25%).

(Fonte: Lenovo, "Cio Playbook 2024", marzo 2024)

“Ci ritorna un’immagine delle aziende Emea di fortissima attenzione all’AI”, ha dichiarato alla stampa Alessandro De Bartolo, country general manager dell’Infrastructure Solutions Group di Lenovo, commentando i risultati dell’indagine. “Interessante è che il 45% degli intervistati abbia detto che l’IT ha qualche difficoltà ad accontentare la richiesta. Questo ci dice innanzitutto che l’AI non è patrimonio solo dell’IT ma è una richiesta trasversale, che giunge anzi spesso dal business. e quindi il dipartimento IT è spesso sotto pressione di fronte alla richiesta di implementare l’intelligenza artificiale”.

De Bartolo ha sottolineato che, nell’avviare un qualsiasi progetto di AI in azienda, vanno considerati fondamentalmente quattro elementi. Il primo sono i dati: non possono scarseggiare, né essere di scarsa qualità o pertinenza. Il secondo è la potenza computazionale, che può essere ricavata internamente (con l’acquisto di nuovi server) o reperita all’esterno, in cloud. Il terzo elemento sono gli algoritmi, e naturalmente la scelta del “cervello” che diventerà fonte di ragionamenti e informazioni è particolarmente critica. Infine le competenze, aspetto non meno importante ed emerso, non a caso, anche dall’indagine di Idc.

Il 60% delle aziende Emea sta già investendo per dotarsi di competenze e abilità sull’AI generativa, o con programmi di formazione ai dipendenti o con nuove assunzioni. Il 56% ha detto che reperire nuovo personale esperto in questo campo è “moderatamente” o “molto” difficile.

Alessandro De Bartolo, country general manager dell’Infrastructure Solutions Group di Lenovo

Lenovo, naturalmente, si inserisce in quest’onda di trasformazione soprattutto come player di infrastruttura e l’indagine commissionata a Idc in parte sfata il mito secondo cui l’intelligenza artificiale debba poggiare solo sul cloud. Questo è vero in parte, per alcune aziende, applicazioni e carichi di lavoro, ma non del tutto. “L’implementazione dell’AI in azienda rappresenterà sempre di più una spinta a ripensare l’adozione del cloud”, ha commentato De Bartolo. “Solo il 17% dei rispondenti pensa che i progetti di AI saranno implementati in un cloud pubblico, il 48% predilige il cloud ibrido e il 24% il private cloud. Questo accade, probabilmente, perché c’è un riconoscimento del fatto che realizzare un progetto di AI non significa solo mettere dei dati in cloud ma anche metterci di Kpi e la logica aziendale”.

“Un tema collegato è quello dell’edge computing”, ha proseguito il country general manager. “Sulla spinta dell’implementazione di progetti di AI c’è anche una spinta all’utilizzo di tecnologie edge. L’AI sempre di più sta intorno a noi, è vicina, gli algoritmi non vengono elaborati solo all’interno delle mura dei data center ma anche ai bordi delle infrastrutture. Succede sia quando le persone usano i propri dispositivi sia attraverso i sensori e i dispositivi IoT: la loro distribuzione richiede che la capacità di elaborare sia molto più vicina ai luoghi in cui i dati vengono creati”.

Retail, manifattura e automotive sono tra gli ambiti che più potranno beneficiare di calcoli di machine learning elaborati “in periferia” ma in generale, secondo l’indagine, le aziende Emea quest’anno aumenteranno del 38% gli investimenti in tecnologie e servizi di calcolo edge. “Anche noi di Lenovo riscontriamo in Italia che il business dell’edge computing è in forte crescita”, ha detto De Bartolo. “A livello nazionale già dallo scorso anno abbiamo visto un enorme dispiego di risorse del Pnrr per implementare capacità elaborativa all’interno del sistema-Paese. Molte gare sono state concluse e siamo protagonisti in molte di esse. Stiamo alimentando la capacità elaborativa per poter poi usare gli algoritmi in ambiti disparati”.