Tempestano i siti Web di richieste, su scala massiccia, per rastrellare dati: sono i bot grigi. Così i ricercatori di sicurezza di Barracuda Networks hanno battezzato i bot di intelligenza artificiale generativa come ClaudeBot (di Antrophic) e Bytespider (di Bytedance) che possono operare come dei Web crawler, ovvero estrarre dati da siti e applicazioni Web su larga scala e in modo totalmente automatico.

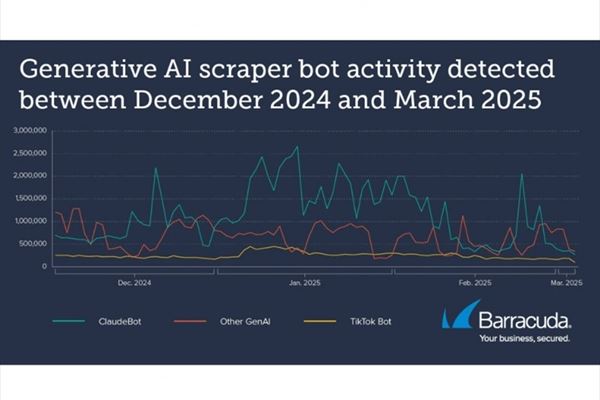

Dai rilevamenti di Barracuda è emerso che tra dicembre 2024 e febbraio 2025 le applicazioni Web hanno ricevuto milioni di richieste da bot basati su GenAI. E c’è stata una singola applicazione Web monitorata da Barracuda che ha registrato 9,7 milioni di richieste di questo tipo in un mese, mentre un’altra ne ha ricvute mezzo milione di richieste in un solo giorno.

Perché preoccuparsi se non si tratta di strumenti malevoli, certamente non concepiti come tali da chi li ha sviluppati? “I bot che noi chiamiamo ‘grigi’ stanno sfumando i confini dell'attività legittima online”, ha spiegato Rahul Gupta, senior principal software engineer, application security engineering di Barracuda. “Sono in grado di estrarre grandi volumi di dati sensibili, proprietari o commerciali e possono sovraccaricare il traffico delle applicazioni Web e portare a un’interruzione delle operazioni. Lo scraping costante operato da questi bot può degradare le prestazioni del Web e la loro presenza può distorcere le analisi dei siti, portando a generare insight fuorvianti e a compromettere il processo decisionale. Per molte organizzazioni, la gestione del traffico di questi bot è diventata ormai una componente chiave delle strategie di sicurezza delle applicazioni”.

(Fonte: Barracuda Networks)

I bot grigi, spiega Barracuda, possono diventare “aggressivi” nella loro attività di raccolta dati, ottenendo informazioni che dovrebbero restare private, per esempio informazioni commerciali o coperte da proprietà intellettuale o protette da normative di settore (pensiamo ai dati sanitari). Da qui possibili problemi di compliance, danno reputazionale e spese legali. I bot potrebbero, inoltre, potrebbero rimuovere informazioni senza averne il permesso.

Ci sono, inoltre, impatti sul funzionamento sui costi di gestione ii siti e applicazioni. Sovraccaricando i server Web di richieste di accesso, i bot grigi possono impattare le prestazioni di un sito Web, con diverse conseguenze: incremento dei costi dell’hosting, compromissione della user experience, declassamento nel ranking dei motori di ricerca, per citare i principali.

Ma ci sono anche altri impatti sul business, forse meno ovvi. Le metriche di utilizzo di un sito Web e applicazione spesso servono alle aziende per orientare decisioni relative alle vendite, al marketing e ad altro ancora, e se tali metriche vengono alterate tali scelte smettono di essere fondate su dati “giusti”. In sostanza, i bot grigi possono addirittura alterare i processi decisionali delle aziende.

Come proteggersi dal Web crawling

Barracuda Networks consiglia ai gestori dei siti Web di proteggersi con un semplice accorgimento: usare un file robots.txt, ossia una riga di codice aggiunta al dominio che indica a uno scraper di non prelevare i dati da quella fonte. Questo accorgimento non risolve però del tutto il problema. La presenza del file robots.txt non è legalmente vincolante ed è necessario aggiungere il nome specifico del bot, ma comunque non tutte le aziende proprietarie di bot basati su GenAI rispettano le linee guida.

Barracuda consiglia, quindi, di adottare soluzioni di difesa evolute, che possano rilevare e bloccare l’attività di Web scraping attraverso capacità di machine learning, di rilevamento dei comportamenti anomali e di blocco delle minacce in tempo reale.