Grazie a Gpt-4o, il nuovo modello presentato da OpenAI, potremo presto dialogare con ChatGpt in modo ancor più realistico, scrivendo ma anche parlando, senza pause innaturali e sapendo che il chatbot comprenderà le nostre intenzioni ed emozioni. E quasi quasi, chiudendo gli occhi, portemmo credere di stare dialogando con una persona in carne e ossa.

Dopo le indiscrezioni dei giorni scorsi, OpenAI ha svelato in live streaming GPT-4o, un modello fondativo che può “ragionare” in forma di conversazione audio, immagini e testo scritto, in tempo reale. La “o” del suffisso sta, infatti, per “omni”, cioè “tutto”, a indicare la capacità di gestire più forme e livelli di comunicazione.

Per migliorare l’esperienza d’uso e in, particolare, il realismo dell’interazione, l’azienda di Sam Altman lavorato sulla velocità: Gpt-4o può reagire a un input vocale in 232 millisecondi come scarto minimo e mediamente in 320 millisecondi, ovvero il tempo tipico di risposta in un dialogo tra esseri umani. Il miglioramento è drastico rispetto ai precedenti modelli, se pensiamo che nella versione di ChatGpt basata su Gpt-3.5 sul canale vocale il chatbot ha, in media, una latenza di risposta pari a 2,8 secondi, mentre in quella basata su Gpt-4 si arriva a 5,4 secondi. Inoltre Gpt-4 non è in grado di cogliere tutte le informazioni nella traccia vocale di input, perdendosi caratteristiche non verbali come il tono di voce. Gpt-4o, invece, riconosce le emozioni nella voce, coglie i rumori di fondo e si accorge se la persona sta ridendo o cantando. Le conversazioni vocali sono più fluide e realistiche anche perché è possibile interrompere il chatbot per porre un’altra domanda o ribattere al volo. In futuro, inoltre, potrà rispondere a sua volta con diverse voci e inflessioni.

Questi risultati sono stati ottenuti grazie a un diverso metodo di training: un singolo modello è stato allenato su testi scritti, immagini e audio. Ciò significa che tutti gli input e gli output vengono processati dalla stessa rete neurale. Ma siamo solo all’inizio di questa nuova evoluzione dell’AI generativa: “Poiché GPT-4o è il nostro primo modello a combinare tutte queste modalità, abbiamo appena iniziato a esplorare le possibilità del modello e le sue limitazioni”, ha scritto l’azienda.

Per quanto riguarda la comprensione linguistica in inglese e l’analisi del codice, Gpt-4o eguaglia le prestazioni di GPT-4 Turbo (il modello premium, fruibile in abbonamento), mentre è migliore di esso sui testi scritti in lingue diverse dall’inglese e, soprattutto, nell’analisi di tracce audio e immagini.

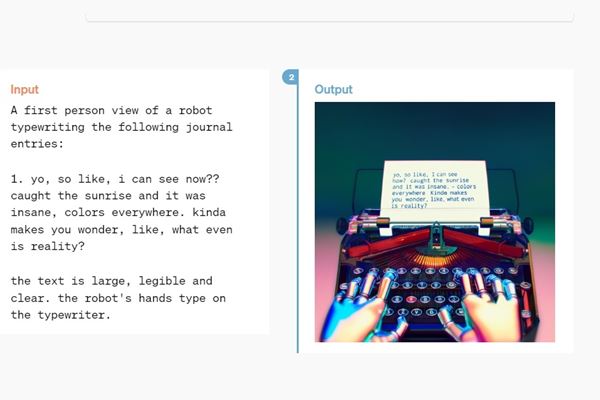

Un esempio delle capacità text-to-image di Gpt-4o (Immagine: OpenAi)

Rischi e limitazioni di Gpt-4o

Nei test effettuati in base al “network di prontezza” di OpenAI, il nuovo modello ha dimostrato di non comportare rischi elevati (ma solo lievi o al massimo “medi”) rispetto alla cybersicurezza, alle capacità di persuasione e all’autonomia. Inoltre Gpt-4o è stato sviluppato in linea con i principi etici sottoscritti dall’azienda su base volontaria, ed è passato al vaglio di oltre settanta esperti esterni, che hanno effettuato prove di red teaming sui possibili rischi di bias, mancata equità, disinformazione. Ciononostante, OpenAI come sempre ha messo le mani avanti, anche perché il riconoscimento delle emozioni da parte delle intelligenze artificiali è un aspetto particolarmente critico, su cui per esempio l’AI Act europeo pone limitazioni e in alcuni casi divieti.

OpenAI, infatti, procederà per gradi, rilasciando inizialmente solo le sole modalità testo (per input e output) e immagini (solo in input). “Riconosciamo che le modalità audio di Gpt-4o presentano una serie di nuovi rischi”, ha scritto l’azienda. “Nelle prossime settimane e mesi lavoreremo sull’infrastruttura tecnica, sull’usabilità tramite post-training e sulla sicurezza necessarie per rilasciare le altre modalità. Per esempio, al lancio, gli output audio saranno limitati a una serie di voci preimpostate e si atterranno alle nostre esistenti policy di sicurezza”. Maggiori dettagli saranno svelati prossimamente.

L’azienda ha garantito che continuerà a mitigare gli eventuali che dovessero emergere. Nel blogpost di presentazione vengono anche illustrate alcune delle attuali limitazioni del modello.

Debutto per tutti, ma graduale

Rispetto a precedenti lanci, Gpt-4o è fin da subito disponibile anche gratuitamente, ma il rollout sarà graduale. Le nuove capacità sono già disponibili per le attività di red teaming ed è anche cominciato il rollout delle modalità testo e immagini in ChatGpt, anche nella versione gratuita dell’applicazione ma con un certo limite sul numero di input giornalieri. Per chi è abbonato a ChatGpt Plus il tetto è cinque volte tanto. La modalità vocale sarà rilasciata nelle prossime settimane in versione alpha all’interno di ChatGpt Plus.

In aggiunta a tutto ciò, Gpt-4o è anche già disponibile per gli sviluppatori, nella modalità testo e immagine, attraverso l’Api di OpenAI. Qui debutteranno anche nuove funzionalità audio e video nelle prossime settimane, ma solo per “un limitato gruppo di partner di fiducia” di OpenAI.