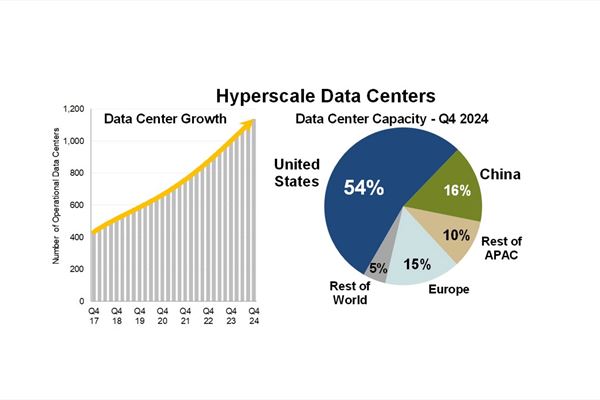

Spuntano come funghi e crescono anche in capacità di calcolo e consumi: sono i data center hyperscale, i “giganti”, come quelli direttamente posseduti o gestiti da cloud provider del calibro di Amazon (Aws), Microsoft e Google o da colossi dei servizi digitali come Apple e Meta. Secondo nuove statistiche di Synergy Research Group, a fine 2024 si contavano nel mondo 1.136 data center con caratteristiche di gigantismo e scalabilità estrema.

Il numero dei centri di elaborazione dati hyperscaler (anche detti cloud data center) è raddoppiato in cinque anni, mentre per il raddoppio della loro capacità di calcolo complessiva ne sono bastati quattro. Questo significa che non soltanto sono state costruite nuove infrastrutture, ma quelle esistenti hanno beneficiato di potenziamenti, popolandosi di nuovi server e appliance con componenti semiconduttori di ultima generazione.

Secondo Fortune Business Insight, il giro d’affari mondiale dei data center hyperscale ha sfiorato nel 2024 i 163 miliardi di dollari (162,79 miliardi), ma ancora non abbiamo visto nulla. Si prospetta, infatti, una crescita a un tasso annuo del 24,6%, per arrivare a 608,5 miliardi di dollari di valore nel 2030.

Che cos’è un data center hyperscale

Mettendo insieme le principali definizioni date da analisti e vendor, sono hyperscale tutti quei data center che non solo si estendono su un’ampia superficie, ma sono progettati per garantire scalabilità estrema, connettività veloce e latenza minima. Sono indicati, quindi, per supportare applicazioni a intenso uso di dati e fortemente dipendenti dalla latenza, per esempio (ma non solo) in ambiti come l’e-commerce, i social media, la ricerca scientifica, la realtà virtuale, il gaming.

Tipicamente, contengono qualche migliaia di server (almeno cinquemila, in base alla tassonomia di Fortune Business Insight). Continuità operativa, gestione termica e contenimento dei consumi energetici sono aspetti critici che impattano sui costi, sulle emissioni inquinanti e anche sul funzionamento stesso di queste complesse infrastrutture.

Un mercato sbilanciato

In base al censimento di Synergy Research Group, metà della potenza di calcolo hyperscale risiede negli Stati Uniti, mentre il 16% è in Cina e il 15% in Europa. Guardandola dal punto di vista degli erogatori dei servizi, Aws, Microsoft Azure e Google Cloud continuano fare la parte del leone: i tre operatori detengono a livello globale (ubicata negli Usa principalmente, ma non solo) il 59% della capacità di calcolo hyperscale.

C’è, dunque, una concentrazione geografica e di mercato molto spinta. Subito fuori dal podio, in termini di capacità di calcolo gestita, si posizionano Meta, Ibm, Alibaba, Tencent, Apple e ByteDance.

Allargando lo sguardo a tutto l’ecosistema, alla catena di fornitura di questo mercato, i grandi nomi sono Nvidia, Intel, Oracle, Cisco, Ibm, Hpe, Infinidat, Pure Storage, Ericsson, Penguin Arista (tutti vendor di componenti o di sistemi infrastrutturali come server, apparati di storage o networking), Vertiv, Eaton, Abb, Energy Vault (gestione energetica e gestione termica) e ancora Equinix, Colt, Ntt e altri (servizi di colocation).

La distribuzione geografica dei data center hyperscale (Fonte: Sinergy Research Group)

Il futuro dei “giganti”

Alla base della spinta che osserviamo ci sono il boom dei dati, di cui sentiamo parlare da almeno un decennio, e l’adozione del cloud nelle sue diverse componenti (servizi di infrastruttura, di piattaforma e applicazioni). Ma più recentemente c’è stata e c’è la forte domanda di infrastrutture, piattaforme e applicazioni per l'intelligenza artificiale. E questa domanda pare ancora lontana dal punto di saturazione: secondo le stime di Synergy Research, la capacità di calcolo degli hyperscaler è destinata a raddoppiare ancora nei prossimi quattro anni.

Presumibilmente, da qui al 2029 apriranno i battenti dai 130 ai 140 nuovi data center hyperscale all’anno, e oggi si contano 504 cantieri aperti o quantomeno pianificati. “Nel 2024 sono stati attivati 137 nuovi data center hyperscale, che hanno proseguito la solida tendenza alla crescita cominciata molti anni fa”, ha commentato John Dinsdale, chief analyst di Synergy Research Group. “La grande differenza di oggi sta nella maggiore dimensione di molti dei nuovi data center”.

Per diversi anni, ha spiegato l’analista, l’allargamento delle planimetrie e delle capacità di calcolo è stato graduale, ma con l’emergere dell’intelligenza artificiale lo scenario è cambiato. Ora si progetta e si costruisce pensando ai carichi di lavoro di AI. Persisteranno, secondo gli analisti, alcuni dualismi nei modelli di business: edifici di proprietà o in gestione, infrastrutture semplicemente grandi o “extra large”, e ancora focalizzate sulla nazione di residenza o su operazioni internazionali.

Complessivamente, la tendenza all’incremento dimensionale è “molto chiara”, ha detto Dinsdale. “Ed è anche molto evidente che gli Stati Uniti continueranno a sovrastare tutti gli altri Paesi e regioni, in quanto principale residenza delle infrastrutture hyperscale”. L’affermazione è forse un po’ troppo baldanzosa ma non infondata, se pensiamo ai grandi investimenti annunciati o già mobilitati, come quelli del progetto Stargate, che vede in primo piano OpenAI, Softbank e Oracle.