Sui large language model, ora Meta fa sul serio ed è pronta a sfidare OpenAI e Google. Llama 2, la seconda e più evoluta versione del large language model sviluppato a Menlo Park, diventa pubblicamente accessibile come modello open source, distribuito via cloud (e in particolare, ma non solo, tramite Azure). La prima versione, Llama 1, era stata messa a disposizione dei ricercatori, registrando oltre 100mila richieste di accesso. Il nuovo modello è disponibile per chiunque, aziende, startup, sviluppatori e ricercatori, e l’utilizzo è gratuito sia per attività di ricerca sia per fini commerciali.

“L’open source favorisce l’innovazione”, ha scritto Mark Zuckerberg, “perché permette a un maggior numero di sviluppatori di creare sulla base della nuova tecnologia”. Una scelta di pura generosità? Probabilmente anche una scelta strategica. Anziché pensare alla monetizzazione immediata, Meta sembra voler fare il possibile per diffondere sul mercato la propria alternativa ai modelli sviluppati da OpenAI e veicolati da Microsoft (in particolare GPT-3.5 e GPT-4), a quelli di Google (Bard) e di Amazon (Titan), senza porre barriere di tipo economico o tecnico.

“Crediamo che un approccio aperto sia quello giusto per lo sviluppo degli attuali modelli di AI, specie quelli dell’ambito generativo, in cui la tecnologia sta facendo rapidi progressi”, si legge nel blogpost che annuncia il lancio. “E crediamo che sia più sicuro. Aprire l’accesso agli attuali modelli di AI significa che una generazione di sviluppatori e ricercatori può testarli sotto stress, identificare e risolvere velocemente i problemi, come community. Osservando come questi strumenti sono utilizzati da altri, i nostri team possono imparare da loro, migliorare questi strumenti e risolvere vulnerabilità”.

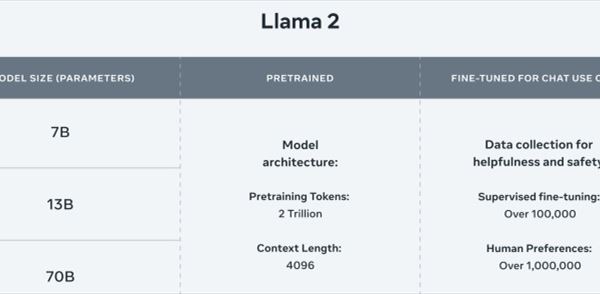

Rispetto alla precedente versione, Llama 2 è stato addestrato su una base di dati il 40% più ampia ed è poi stato affinato con oltre un milione di annotazioni “manuali” del personale di Meta. Il seguente grafico compara alcune caratteristiche tecniche (qui la panoramica completa).

Rapporto preferenziale con Microsoft

Non essendo un cloud provider, a differenza di Microsoft, Google e Amazon l’azienda di Menlo Park deve affidarsi ad altri per veicolare il proprio large language model. E non ha fatto una scelta esclusiva ma in qualche modo si è schierata. Come già annunciato da Satya Nadella durante la conferenza “Microsoft Inspire”, Meta ha scelto l’azienda di Redmond come suo partner preferenziale per l’intelligenza artificiale generativa.

Dunque Llama 2 è stata inserita tra gli altri modelli già presenti sul catalogo di Azure (i clienti possono scegliere di affinare e distribuire i modelli di Llama 2 contenenti 7 miliardi, 13 miliardi e 70 miliardi di parametri), ma è anche disponibile attraverso Aws, Hugging Face e altri provider.

L’accordo con Microsoft interessa però soprattutto gli sviluppatori e le aziende che vogliano affinare il modello con dati proprietari. Llama 2 è infatti ottimizzato per l’esecuzione in locale su macchine Windows, e gli sviluppatori possono utilizzare come strumenti di lavoro Windows Subsystem per Linux, Windows terminal, Microsoft Visual Studio e VS Code.

L’impegno di Qualcomm per l’AI su smartphone e visori

Aziende partner del progetto di Meta sono anche Accenture, Amd, Dropbox, Ibm, Intel, Palo Alto Networks e altre, accanto a università, associazioni e centri di ricerca. E poi c’è Qualcomm, che sta collaborando con Menlo Park per ottimizzare l’esecuzione dei large language model di Llama 2 direttamente sui dispositivi e senza ricorrere esclusivamente ai servizi cloud. Per dispositivi si intendono in questo caso i Pc ma anche gli smartphone, i visori di realtà virtuale e aumentata e i sistemi di infotainment per automobili.

Lavorare in locale, spiega Qualcomm, “consente agli sviluppatori di risparmiare sui costi del cloud e di fornire agli utenti esperienze private, più affidabili e personalizzate”. L’azienda proporrà a partire dall’anno prossimo delle implementazioni di intelligenza artificiale basata su Llama 2 sui dispositivi con processore Snapdragon.

"Apprezziamo l'approccio di Meta all'AI aperta e responsabile e ci impegniamo a promuovere l'innovazione e a ridurre le barriere all'ingresso per gli sviluppatori di qualsiasi dimensione portando l'AI generativa sui device", ha dichiarato Durga Malladi, senior vice president e general manager delle attività di tecnologia, pianificazione e soluzioni edge di Qualcomm. “Per far entrare efficacemente l'AI generativa nel mainstream, l'AI dovrà essere eseguita sia sul cloud che sui dispositivi edge, come smartphone, laptop, veicoli e dispositivi IoT".

Una promessa di responsabilità

Con il lancio di Llama 2, Meta ha ribadito il proprio impegno per un’intelligenza artificiale responsabile. Una promessa simile a quelle fatte da OpenAI, Microsoft, Alphabet, Amazon, e che nel caso dell’azienda di Mark Zuckerberg si fonda su alcune azioni concrete. Innanzitutto le attività di red-teaming con cui Meta ha testato i propri modelli sottoposti a fine-tuning, e l’impegno a proseguire su questa linea e a presentare futuri aggiornamenti.

Uno tra i modelli già perfezionati, ottimizzato per applicazioni conversazionali, è Llama 2-Chat. A beneficio della trasparenza (il secondo impegno di AI responsabile portato avanti da Meta) l’azienda ha dettagliato in un documento le ottimizzazioni e i miglioramenti di sicurezza apportati al modello open-source di partenza durante il fine-tuning.

In terzo luogo, Meta ha messo nero su bianco una policy che chiarisce il divieto di utilizzo dei suoi modelli per attività illegali, frodi, istigazione all’odio, violenza, discriminazione, abusi di esercizio professionale e altro ancora. Infine l’azienda si è impegnata a supportare la ricerca accademica nel campo dell’AI responsabile, con un nuovo programma ad hoc, e ha lanciato una challenge (Llama Impact Challenge, le cui regole di partecipazione saranno annunciate prossimamente) per chi voglia sviluppare applicazioni basate su Llama utili per l’ambiente, l’istruzione la società.