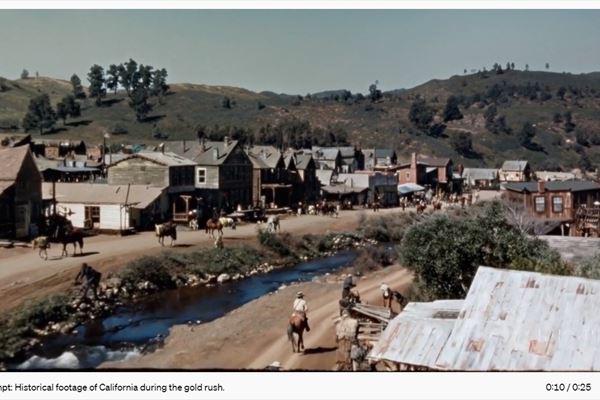

(Fotogramma di video generato da Sora)

L’intelligenza artificiale generativa di OpenAI ora può anche creare dei video a partire da comandi testuali. Si chiama Sora il nuovo modello presentato dall’azienda di Sam Altman, già apripista del text-to-text con ChatGpt e del text-to-image con Dall-E: può generare istantaneamente dei clip video della durata massima di un minuto, con il soggetto, l’azione, i dettagli e lo stile grafico indicati nel prompt testuale.

Dando la giusta indicazione si possono creare anche scene complesse, con uno o più personaggi, che si muovono in uno specifico modo su sfondi ricchi di dettagli. Addirittura, si possono dare indicazioni sulla lente e sulla traiettoria della immaginaria videocamera che riprende la scena (fissa, carrello all’indietro o anche immagine aerea catturata da un drone). Inoltre è possibile allungare uno spezzone video esistente creando nuovi fotogrammi oppure “animare” un’immagine fissa. Il risultato, quindi, può essere più o meno realistico o assomigliare a un clip di animazione digitale. L’esperienza d’uso è simile a quella delle altre applicazioni di AI generativa già popolari, come ChatGpt, Midjourney o Bard.

Fotogramma tratto da un video generato da Sora

Come funziona Sora

Oggi già esistono e sono facilmente disponibili di Web molte applicazioni text-to-video, che creano contenuti anche già pronti all’uso su piattaforme come YouTube e TikTok. Ma per la prima volta OpenAI ha presentato una tecnologia di questo tipo, che dalle anteprime mostrate pare più evoluta e raffinata rispetto a soluzioni concorrenti.

Partendo dall’esperienza dei large language model già sviluppati, come le diverse versioni di Gpt e Dall-E, è stato creato un modello che sa comprendere le istruzioni testuali e trasformarle in video, “in modo più fedele”, ha spiegato l’azienda. Sora è un modello di diffusione, cioè un tipo di apprendimento automatico che progressivamente aggiunge “rumore” ai dati usati nel training, per poi eseguire il processo inverso (qui maggiori dettagli tecnici).

“Rappresentiamo video e immagini come una raccolta di unità di dati più piccole, chiamate patch, ciascuna delle quali è simile a un token di Gpt”, ha spiegato OpenAI. “Unificando il modo in cui rappresentiamo i dati, possiamo allenare un transformer di diffusione su un ventaglio di dati visuali più ampio di quanto possibile precedentemente, variando tra diverse durate, risoluzioni e proporzioni”.

Fotogramma di un video generato da Sora: il prompt può dare indicazioni sullo stile e sull'epoca della "ripresa"

I rischi e i difetti da correggere

Al momento non è ancora possibile provare Sora: questa novità disponibile solo per un ristretto numero di sviluppatori, e che stanno effettuando verifiche di red teaming. Si vuole evitare che questa tecnologia possa alimentare pregiudizi o si presti a tentativi di incitazione all'odio, violazioni di copyright, disinformazione, diffusione di deepfake, violenza o volgarità. “Stiamo compiendo passi importanti per la sicurezza prima di rendere disponibile Sora”, ha scritto l’azienda. OpenAI sta anche sviluppando alcuni strumenti “che aiutino a individuare i contenuti ingannevoli, come un classificatore di detection che può indicare se un video sia stato generato con Sora”.

Nel caso il modello diventi un prodotto commerciale, saranno introdotti dei metadati C2PA che permetteranno di tracciare i contenuti video e risalire al modo in cui sono stati creati. All’interno dell’applicazione, un classificatore valuterà i prompt testuali per poter rifiutare qualsiasi richiesta che violi le policy di OpenA, per esempio tentativi di creare contenuti violenti, espliciti, ingannevoli o che rubino la proprietà intellettuale o l’immagine altrui (come già accaduto con tecnologie simili, usate per creare spot pubblicitari con i finti Tom Hanks e Scarlett Johansson come testimonial).

Anche la qualità dell’output di Sora dev’essere ancora perfezionata. Per ammissione della stessa OpenAI, attualmente il modello potrebbe fraintendere alcuni elementi di un prompt o non riuscire a riprodurre la traiettoria di movimento richiesta, o ancora potrebbe non rispettare le logiche di causa/effetto (per esempio, mostrando una persona che morde un biscotto e un attimo dopo lo stesso biscotto non ancora morsicato) o le leggi della fisica (riproducendo movimenti impossibili, per esempio). La società di San Francisco sta anche raccogliendo feedback da registi, designer e artisti dell’immagine, cioè (un po’ paradossalmente) dalle professioni che potrebbero sentirsi minacciate da tecnologie come questa. A detta di OpenAI, l’obiettivo è di rendere Sora uno strumento “utile per i creativi professionisti”.