In un mercato in cui il 75% delle aziende considera strategica l’adozione dell’AI, Dell Technologies propone il suo modello mirato a superare gli ostacoli legati alla qualità dei dati, alla sicurezza e ai costi. L’architettura proposta – e illustrata a Las Vegas nel corso dell'annuale evento rivolto a partner e clienti – dovrebbe consentire un significativo risparmio in fase di inferenza di modelli linguistici di grandi dimensioni, con risparmi fino al 62% rispetto a soluzioni in cloud pubblico. Questo approccio permette alle imprese di gestire i carichi AI in modo flessibile, su infrastrutture di proprietà, mantenendo al tempo stesso un elevato livello di sicurezza e controllo.

Innovazione infrastrutturale per AI ad alte prestazioni

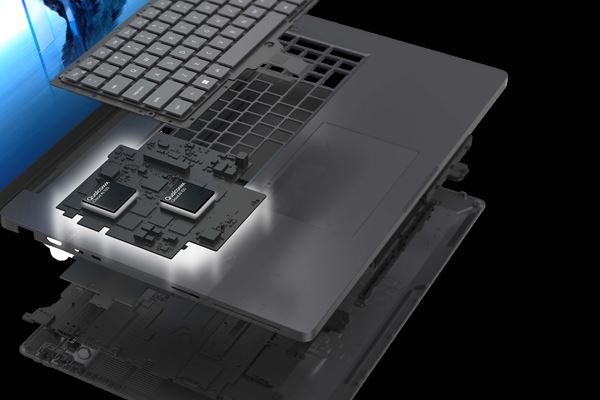

Dell introduce nuove soluzioni hardware per la gestione di AI su larga scala, a partire dalle workstation mobili Dell Pro Max Plus, le prime dotate di NPU discrete di livello enterprise, capaci di eseguire in locale modelli da oltre 100 miliardi di parametri. L’integrazione della scheda Qualcomm AI 100 PC potenzia le capacità di inferenza edge, offrendo prestazioni elevate a chi sviluppa e implementa modelli complessi in mobilità.

Nel segmento data center, Dell propone l’adozione di nuove soluzioni per il raffreddamento con l’innovativo sistema PowerCool eRDHx, capace di abbattere i costi energetici fino al 60% rispetto agli scambiatori tradizionali. Integrato nei rack IR7000, consente una densità superiore del 16% e raffreddamento fino a 80 kW per rack, con gestione unificata dei componenti.

Dell espande la propria offerta server con i modelli PowerEdge XE9785 e XE9785L, ora compatibili con le GPU AMD MI350, progettate per carichi intensivi di AI e HPC. Questi sistemi garantiscono una capacità di elaborazione fino a 35 volte superiore rispetto alle generazioni precedenti e sono disponibili con opzioni di raffreddamento ad aria o a liquido.

La gestione dei dati rappresenta un elemento cardine per l’efficacia delle soluzioni AI. Con Project Lightning, Dell propone il file system parallelo, a suo dire, più veloce al mondo in grado di raddoppiare il throughput rispetto alla concorrenza. Le evoluzioni del Data Lakehouse, inoltre, rendono più efficienti casi d’uso come recommendation engine, ricerche semantiche e analisi predittive, preparando i dataset all’uso immediato.

Dell rafforza anche la componente di sicurezza e governance con i nuovi AI Security and Resilience Services, garantendo protezione completa per dati, modelli e applicazioni. Grazie a Linear Pluggable Optics, è possibile ottimizzare consumi e latenza, migliorando l’efficienza di ambienti HPC e AI distribuiti.

Ecosistema di partner e applicazioni personalizzabili

La strategia Dell si fonda su un solido ecosistema di partner: collaborazioni con Cohere, Google, Meta, Glean e Mistral AI consentono l’integrazione di modelli avanzati e soluzioni AI agentiche direttamente su infrastrutture aziendali. In particolare, Cohere North e Google Distributed Cloud abilitano flussi intelligenti on-premises, mentre le architetture con Llama e Glean favoriscono lo sviluppo di AI conversazionali sicure e scalabili.

Con oltre 3.000 aziende già supportate a livello globale, Dell AI Factory rappresenta una piattaforma matura per l’adozione dell’AI in tutti i contesti, dal mondo accademico alla ricerca ambientale fino alle imprese di ogni settore. Grazie al supporto di acceleratori come Intel Gaudi 3, la roadmap si arricchisce di nuove funzionalità, fornendo a chi vuole creare una infrastruttura AI on premise tutto quello che serve per farlo in maniera efficiente e organizzata.