Intelligenza artificiale in tutte le salse, generativa e agentica, per il tempo libero e per il lavoro: gli annunci della conferenza Google I/O passano necessariamente da qui, che si tratti di motori di ricerca o contenuti video, di attività lavorative come la creazione di documenti e presentazioni oppure di shopping online. L’azienda di Mountain View utilizza tre aggettivi per qualificare la propria AI: intelligente (un po’ una tautologia, ma per Google significa un’AI sempre più veloce e dotata di capacità), “agentica” (cioè agente, se volessimo attenerci al vocabolario italiano, ma il neologismo è ormai entrato nel lessico comune) e personalizzata.

“Più intelligenza è disponibile per tutti e ovunque”, ha detto l’amministratore delegato di Alphabet e di Google, Sundar Pichai, nel suo keynote. Come fatto notare, un po’ provocatoriamente, da Mit Technology Review, l’ubiquità dell’intelligenza artificiale diventa una forma di invisibilità: se questa tecnologia è ovunque, finiremo per non percepirla più come qualcosa di ulteriore, degno di nota. Diventerà la normalità, come Internet, come il cloud.

Google da un lato sta espandendo i confini dell’AI, accelerando anche sui Large Language Model (Gemini) e sui prodotti rivolti agli sviluppatori; dall’altro lato, sta lavorando per trasformare il suo prodotto principe, il motore di ricerca, in una sorta di convergenza con il mondo dei chatbot e degli agenti AI.

Motore di ricerca e dintorni

Nel menu di Google I/O c’è la AI Mode, una funzionalità di ricerca front-end basata su LLM, già annunciata lo scorso marzo e inizialmente disponibile solo per gli iscritti al programma Labs: ora è in fase di rollout negli Stati Uniti, il che è un preludio alla futura disponimbilità generale.

AI Mode è qualcosa di ulteriore rispetto alle AI Overviews che sempre più spesso compaiono in risposta a una query sul motore di ricerca: funziona, infatti, come un chatbot integrato in Google Search, che l’utente può interrogare cliccando sulla scheda dedicata, per ottenere (per esempio) informazioni su uno specifico argomento o comparazioni tra prodotti. Alla base c’è ora una versione personalizzata di Gemini 2.5, che nell’ultimo aggiornamento ha sostituito Gemini 2.0.

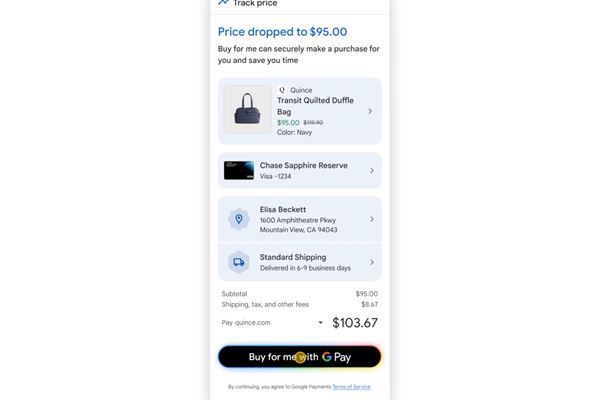

Non è tutto: nell’AI Mode è ora integrato anche un agente di AI, evoluzione del prototipo di Project Mariner e che rappresenta un po’ la risposta di Google all’Operator di OpenAI. Al pari di quest’ultimo, l’agente di Google Search può compiere in autonomia alcune azioni, come acquisti e prenotazioni di prodotti e servizi, per esempio concerti, eventi sportivi o cene al ristorante. L'agente può anche monitorare i prezzi di un certo articolo e acquistarlo in automatico se online compare un'offerta o un ribasso. Ticketmaster, StubHub, Resy e Vagaro sono i primi affiliati al progetto.

(Immagine: Google)

Avanti sull'AI generativa, tra Web e video

La notizia forse più rilevante è però forse un’altra, cioè il debutto (per ora solo annunciato, ma è questione di poco) di Gemini su Chrome. L’assistente di AI sarà integrato direttamente nell’applicazione desktop del browser e potrà interagire con l’attività di navigazione e anche, in autonomia, leggere i contenuti di una pagina Web per trovare informazioni che interessano all’utente. Il rollout è cominciato, al momento, solo negli Stati Uniti.

Diversi altri annunci riguardano ancora Gemini. La variante “light” del modello, cioè Gemini 2.5 Flash, dopo il recente lancio è diventata ora l’LLM predefinito per i servizi di Google. L’azienda ha però lavorato anche sulla variante “pro”, ribattezzata Gemini 2.5 Pro Deep Think e destinata a particolari utilizzi: la caratteristica distintiva è la capacità di ragionamento parallelo (parallel thinking), un tipo di elaborazione che permette al modello di affrontare problemi di particolare complessità, per esempio di matematica o di programmazione.

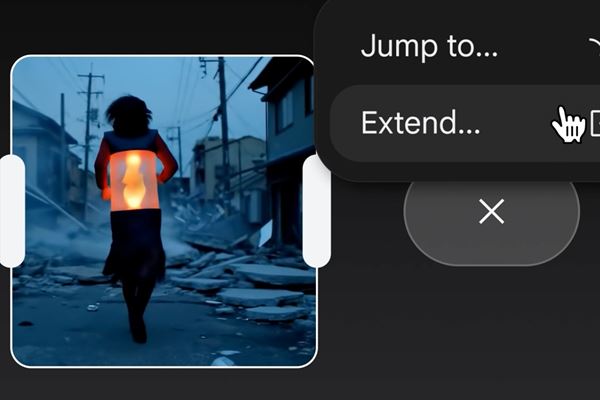

Sempre nell’ambito dei Large Language Model, altre novità è Flow: un'applicazione di intelligenza artificiale generativa per la creazione di video. Rispetto ad alternative simili, si differenzia per il fatto di includere una serie di strumenti di “regia e montaggio”, per così dire, come la possibilità di scegliere l’angolo di visione e i movimenti della macchina da presa (per così dire), di aggiungere transizioni video, di allungare il contenuto un prompt dopo l'altra, descrivendo di volta in volta la scena successiva. Prossimamente, saranno aggiunti a Flow anche strumenti che aiutano a organizzare i contenuti già creati e i prompt salvati.

Il fotogramma di un video creato con Flow (Credits: Google)

Gemini in Workspace e su smartphone

Per utenti e aziende abbonate a Google Workspace debuttano alcune novità, ancora una volta basate sulla tecnologia di Gemini. Quest’ultima ha migliorato le proprie capacità di comprensione contestuale dei messaggi di Gmail e inoltre permette di creare video sintetici a partire da documenti di testo o slide. Nelle videochat su Meet, inoltre, l’assistente di GenAI può realizzare traduzioni in tempo reale sul parlato dei partecipanti (per ora questa funzione supporta (inglese, italiano, francese, spagnolo e portoghese).

Un’altra novità riguarda Gemini Live, lo strumento chatbot integrato in diverse applicazioni Google, come Calendar e Maps: oltre a usare i comandi vocali, è ora possibile usare la fotocamera dello smartphone (Android e iOS) per inquadrare un qualsiasi oggetto e usare quell’immagine come prompt.

Sempre a proposito di Gemini Live, diventano ora accessibili a tutti gli utenti Android e iOS le funzionalità di Project Astra, che permettono la condivisione in tempo reale dello schermo o della videocamera. Google ha già anticipato che altre novità arriveranno nelle prossime settimane. “Gemini Live si integrerà più a fondo nella vostra quotidianità”, ha scritto Josh Woodward, vicepresidente dei Google Labs. “State pianificando una serata fuori con gli amici? Condividetene i dettagli in Gemini Live, che creerà immediatamente un evento nel vostro Google Calendar. Avete voglia di una pizza romana? Chiedete, e Google Maps vi consiglierà i migliori ristoranti nelle vicinanze. Stiamo per integrare Google Maps, Calendar, Tasks e Keep e abbiamo in programma altre connessioni con l’ecosistema Google”. Sarà possibile gestire e modificare in qualsiasi momento le connessioni tra Gemini Live e le applicazioni Google installate sullo smartphone.

Videoconferenze in 3D con Google Beam

La tecnologia di Project Starline, presentata per la prima volta nel 2021, esce ora dalla fase sperimentale e diventa Google Beam. Si tratta di una tecnologia che dà “la sensazione di condividere la stessa stanza con un'altra persona, pur trovandosi a grande distanza”, come spiegato da Andrew Nartker, general manager del progetto. In sostanza, è un’evoluzione dei (tipicamente molto costosi) sistemi di telepresenza potenziata dall’intelligenza artificiale.

Beam è una piattaforma hardware e software di comunicazione video che può trasformare gli stream a due dimensione in video tridimensionali, grazie ad algoritmi di AI e a un sistema di sei videocamere che riprendono la scena e tracciano i movimenti delle persone con precisione millimetrica e a 60 frame al secondo. I dati vengono elaborati su Google Cloud. Realizzati in collaborazione con HP, i sistemi Google Beam saranno disponibili per i primi clienti entro la fine dell'anno. Un lusso forse, più che una necessità, ma certo una dimostrazione ulteriore del rapido progresso tecnico dell'intelligenza artificiale.

(Immagine: Google)