Nvidia è senza dubbio uno tra i grandi protagonisti della rivoluzione dell’intelligenza artificiale generativa. Entrata nel “trillion dollar club” delle società da oltre mille miliardi di dollari di capitalizzazione (una élite di cui cui fanno parte anche Apple, Microsoft, Alphabet e Amazon) grazie a un incremento del proprio valore del 180% nei primi cinque mesi dell’anno, l’azienda produttrice di semiconduttori prosegue nello sviluppo tecnologico focalizzandosi, appunto, su quella AI generativa che in questi ultimi tempi le sta garantendo tale crescita.

La società sta anche proseguendo sul terreno delle alleanze tecnologiche: la più recente è quella avviata con Snowflake, uno specialista degli analytics in cloud. Snowflake utilizzerà le Gpu di Nvidia per attività di calcolo accelerato e la piattaforma NeMo per lo sviluppo di large language model, che i clienti potranno poi personalizzare per creare applicazioni di vario tipo, come chatbot e programmi per la generazione di testi e la ricerca testuale.

I clienti avranno il vantaggio di poter fare tutto questo utilizzando i loro dati proprietari (grezzi o informazioni elaborate, da centinaia di terabyte a petabyte) senza doverli spostare: resteranno, infatti, nel Data Cloud di Snowflake.

“I dati sono essenziali per creare applicazioni di AI generativa che comprendano le complesse operazioni e la voce unica di ciascuna azienda”, ha commentato il fondatore e Ceo di Nvidia, Jensen Huang. “Insieme, Nvidia e Snowflake creeranno una fabbrica di AI che aiuta le aziende a trasformare i propri dati di valore in modelli di AI generativa personalizzati, per alimentare nuove applicazioni pionieristiche, direttamente dalla piattaforma cloud che già usano per mandare avanti il loro business”.

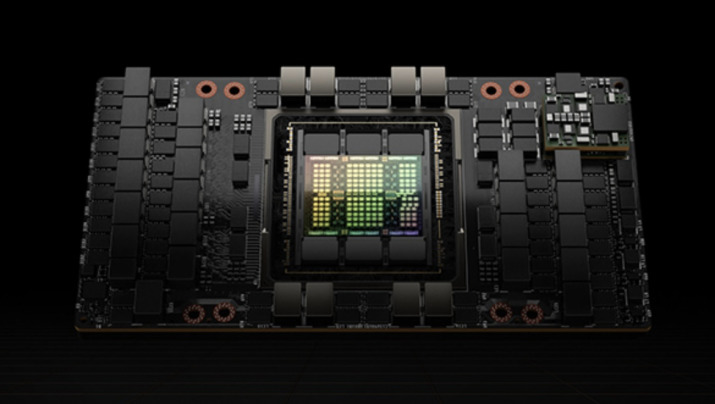

Sul cammino dell’AI generativa Nvidia sta raccogliendo non solo molti profitti ma anche primati. Nell’ultima valutazione di benchmark fatta da MLPerft, le Gpu H100 Tensor Core sono risultate vincenti in tutti e otto i test, in quanto hanno garantito le migliori prestazioni nell’esecuzione di large language model eseguiti, sistemi di raccomandazione, sistemi di visione computerizzata, imaging medico e riconoscimento vocale. Le Gpu H100, anzi, hanno segnato nuovi record in tutti e otto i test, sia considerando il singolo acceleratore sia le prestazioni su server su larga scala.