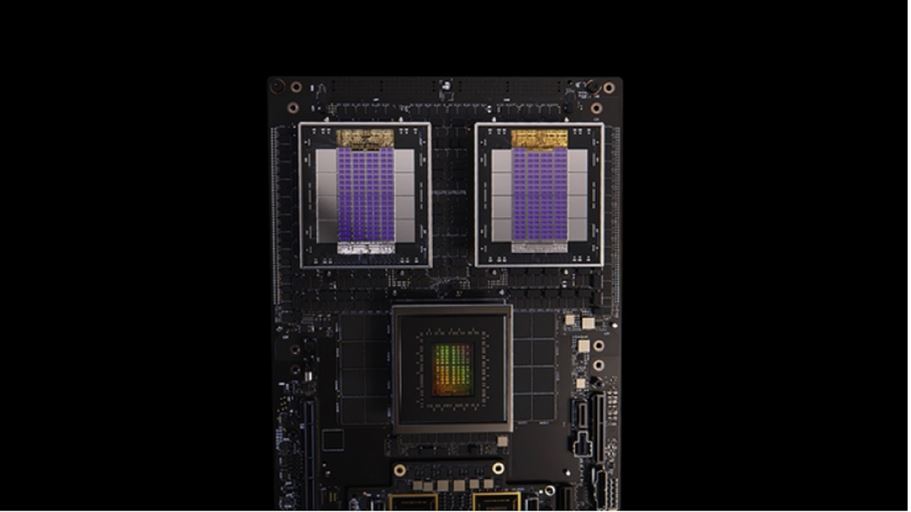

Nvidia NvLink Fusion (Immagine: Nvidia)

Nvidia non si ferma: l’azienda sinonimo di processori avanzati per l’intelligenza artificiale lancia una tecnologia per gli scambio di dati chip-to-chip e, in collaborazione con alcuni partner, un marketplace di Gpu “a servizio”, fruibili in cloud. In visita a Taiwan per la fiera Computex di Taipei, accolto come una rockstar (visti anche i suoi natali taiwanesi), con tanto di bagni di folla e bodyguard, l’amministratore delegato Jensen Huang ha annunciato NVLink Fusion, una variante della tecnologia di interconnessione NVLink di Nvdia, che permetterà ad altri sviluppatori di chip di creare piattaforme di calcolo complesse.

NVLink Fusion consente, più precisamente, di creare sistemi di calcolo per l’AI unendo i processori Grace e le Gpu Blackwell di Nvidia a Cpu e processori Asic di altri sviluppatori. Arrivata alla quinta generazione, la tecnologia NVLink permette scambi di dati su larghezza di banda massima di 1,8 TB/s. Marvell Technology e MediaTek sono tra i primi clienti ad aver annunciato di voler usare NVLink Fusion per la creazione di chip customizzati.

Al Computex, Huang ha anche detto che il supercomputer Dgx Spark, indirizzato a chi fa attività di ricerca sull’intelligenza artificiale, è attualmente in piena produzione e tra poche settimane sarà finalmente sul mercato. Le nuove Gpu Blackwell Ultra, invece, saranno disponibili nei prossimi mesi.

Un marketplace di Gpu in cloud

Un’altra novità in arrivo è Dgx Cloud Lepton, che è allo stesso tempo una piattaforma di calcolo AI e un marketplace su cui acquistare (o meglio affittare) Gpu in cloud. Nvidia cerca, così, di intercettare la platea di circa 5 milioni di sviluppatori (secondo Idc) che lavorano con le sue tecnologie e che potrebbero non volere o poter acquistare hardware fisico.

Tramite Dgx Cloud Lepton saranno fruibili decine di migliaia di Gpu, messe a disposizione da fornitori cloud come CoreWeave, Crusoe, Firmus, Foxconn, Gmi Cloud, Lambda, Nebius, Nscale, Softbank Corp e Yotta Data Services. Al momento i tre principali hyperscaler, cioà Microsoft (Azure), Amazon (Aws) e Google (Google Cloud), non hanno sposato l’iniziativa, ma Nvidia ha fatto sapere che il sistema è già predisposto per supportare un loro futuro coinvolgimento.

La possibilità di fruire Gpu anche di natura avanzata tramite cloud, naturalmente, non è un fatto nuovo. Ma finora, a detta di Nvidia, la loro attivazione tramite servizi cloud non è stata così immediata e ha richiesto un lavoro di ricerca manuale. Il marketplace di Dgx Cloud semplifica e automatizza la ricerca, consentendo anche di scegliere Gpu in data center che risiedono in specifiche regioni geografiche, per eventuali esigenze di compliance.

“Nvidia Dgx Cloud Lepton collega la nostra rete globale di fornitori di Gpu in cloud con gli sviluppatori di AI”, ha dichiarato Huan, accennando poi al programma di certificazione Nvidia Certified Professional (Ncp). “Insieme al nostro Ncp, stiamo costruendo una fabbrica di AI di scala planetaria”. Gli sviluppatori possono già registrarsi per l’accesso anticipato a Dgx Cloud Lepton.

Un'immagine del supercomputer ABCI-Q (Immagine: Nvidia)

Tra supercalcolo e quantum dei record

Il Computex di quest’anno è anche il palcoscenico su cui mostrare la posizione di Nvidia nel supercalcolo e nel calcolo quantistico. Il centro nazionale taiwanese per l'High Performance Computing ha annunciato un nuovo “supercervello” destinato ad attività di ricerca sul quantum: entrerà in funzione entro la fine dell’anno. Costruito da Asus, conterrà cluster di calcolo basati su Nvidia Hgx H200, per un totale di 1.700 Gpu, oltre a due sistemi di scala rack Nvidia GB200 NVL72 e a un sistema HGX B300 basato su Gpu Blackwell Ultra.

I “superchip” Nvidia Grace Hopper alimenteranno i sistemi di calcolo quantistico e calcolo accelerato per l’AI di aziende del settore, come Atlantic Quantum, Quantum Circuits e QuEra Computing, oltre che di atenei come l’Università di Edinburgo e l’Università di Oxford.

Ma per trovare la tecnologia di Nvidia all’interno di un sistema di calcolo da record bisogna andare in Giappone. Qui ha aperto le porte il Global Research and Development Center for Business by Quantum-AI Technology, che ospita il più potente supercomputer dedicato ad attività di ricerca sul calcolo quantistico: ABCI-Q. Il centro di ricerca è gestito dall’istituto nazionale di scienze industriali e tecnologie avanzate giapponese.

Annunciato lo scorso anno, ABCI-Q porta la firma di Fujitsu e incorpora oltre duemila Gpu Nvidia H100, su oltre 500 nodi di calcolo interconnessi con tecnologia Nvidia Quantum-2 InfiniBand. Il sistema servirà per testare applicazioni pratiche di calcolo quantistico per settori come la medicina, l’energia e i servizi finanziari.

Nessun downgrade di Hopper H20 per la Cina

Durante la sua visita a Taipei, Huang ha smentito le recenti voci su un possibile downgrade delle Gpu Hopper H20 destinate al mercato cinese. A detta delle indiscrezioni, Nvidia starebbe progettato delle versioni “light” di questi componenti in modo da aggirare le restrizioni all’export statunitense in Cina.

Alla stampa locale, però, il Ceo ha detto che la piattaforma che permetterà a Nvidia di restare sul mercato cinese non è Hopper, perché “non è possibile modificare ulteriormente Hopper”. In ogni caso, a prescindere dal nome del chip, è altamente probabile che l’azienda stia lavorando allo sviluppo di una Gpu che possa supportare i workload di intelligenza artificiale delle Big Tech cinesi (tra cui Alibaba, Bytedance e Tencent) senza però incappare nelle limitazioni del Framework for Artificial Intelligence Diffusion statunitense.